采用分类经验回放的深度确定性策略梯度方法

强化学习(Reinforcement learning, RL)中, Agent采用“试错”的方式与环境进行交互, 通过从环境中获得最大化累积奖赏寻求最优策略[1]. RL算法根据Agent当前所处状态求解可执行动作, 因此RL适用于序贯决策问题的求解[2]. 利用具有感知能力的深度学习作为RL状态特征提取的工具, 二者结合形成的深度强化学习(Deep reinforcement learning, DRL)算法是目前人工智能领域研究的热点之一[3-4].

在线DRL算法采用增量式方法更新网络参数, 通过Agent与环境交互产生经验样本

本文主要贡献如下:

1) 采用双经验缓冲池存储经验样本, 并根据经验样本中的TD-error和立即奖赏值完成对样本的分类;

2) 从每个经验缓冲池中选取不同数量的经验样本进行网络参数更新;

3) 在具有连续动作空间的RL任务中进行实验, 结果表明, 相比随机采样的DDPG算法, 本文提出的基于时序差分误差样本分类的深度确定性策略梯度方法(DDPG with temporal difference-errer classification, TDC-DDPG)和基于立即奖赏样本分类的深度确定性策略梯度方法(DDPG with reward classification, RC-DDPG)能够取得更好的实验效果. 并与置信区域策略优化(Trust region policy optimization, TRPO)算法以及近端策略优化(Proximal policy optization, PPO)算法进行比较, 进一步证明了本文所提出算法的有效性.

1. 背景

1.1 强化学习

马尔科夫决策过程(Markov decision process, MDP)是序贯决策的经典形式, 其中动作不仅影响到立即奖赏, 同样影响后续的状态或动作, 以及采取后续动作所获得的未来奖赏. 因此, 通常使用MDP对RL问题进行建模, 将RL问题定义为一个五元组

Agent执行的动作由策略

状态动作值函数

| (1) |

| (2) |

迭代计算贝尔曼方程可实现值函数的收敛. 当前时刻状态动作估计值函数与更好地估计

| (3) |

通过求解状态动作值函数仅局限于解决具有离散动作空间的RL问题, 面对具有连续动作空间的RL问题, 策略梯度方法提供了解决问题的方式[9].

1.2 深度确定性策略梯度方法

RL算法分为基于值函数和基于策略两种方法. 基于策略的方法可以解决大状态动作空间或连续动作空间RL问题[10]. 确定性策略梯度(Deterministic policy gradient, DPG)方法以行动者−评论家(Actor-critic, AC)算法为基础, 通过行动者将状态映射到特定动作, 评论家利用贝尔曼方程实现值函数的收敛[11-12].

DDPG中, 使用深度神经网络作为非线性函数逼近器构造行动者

| (4) |

网络模型学习时, 评论家网络通过最小化损失函数

| (5) |

其中,

| (6) |

行动者网络采用蒙特卡罗方法进行采样以逼近期望值, 可通过链式法则近似更新行动者网络参数, 如式(7)所示

| (7) |

目标网络采用“soft”更新方式, 通过缓慢跟踪学习的网络更新参数

| (8) |

“soft”更新方式使得不稳定问题更接近于监督学习, 虽减慢了目标网络参数更新速度, 但在学习过程中能够获得更好的稳定性.

DDPG同样用到了经验回放机制, 将行动者网络与环境交互产生的经验样本

2. 采用分类经验回放的DDPG算法

本节将介绍CER-DDPG算法的思想和结构, 对采用的分类方法分析说明, 最后描述算法流程并分析.

2.1 分类经验回放

经验回放机制在消除数据样本之间关联性的同时能够提高样本利用率. 在Agent与环境交互产生的经验样本中, 不同经验样本对网络训练所起作用不同, 某些经验样本比其他经验样本更能有效地促进网络模型学习. 等概率选取每一个经验样本会在简单样本上花费较多的时间, 增加了算法训练时间步数. 因此, 本文所提出的分类经验回放方法最主要的一点是对不同重要性程度经验样本分类存放, 在网络模型学习时分别从不同类别经验样本中选取每批次样本数据. 对于重要性程度高的经验样本, 每批次以较多数量选取, 同时为保证样本数据多样性, 每批次选取少量重要性程度低的经验样本.

TDC-DDPG中, 使用两个经验缓冲池存放经验样本. 初始化网络模型时, 将两个经验缓冲池中所有样本TD-error的平均值设置为0. 每产生一条新的经验样本, 首先更新所有经验样本TD-error的平均值, 再将该条样本数据的TD-error与平均值进行比较, 若该经验样本中的TD-error大于所有样本TD-error的平均值, 则将该样本存入经验缓冲池1中, 否则存入经验缓冲池2中.

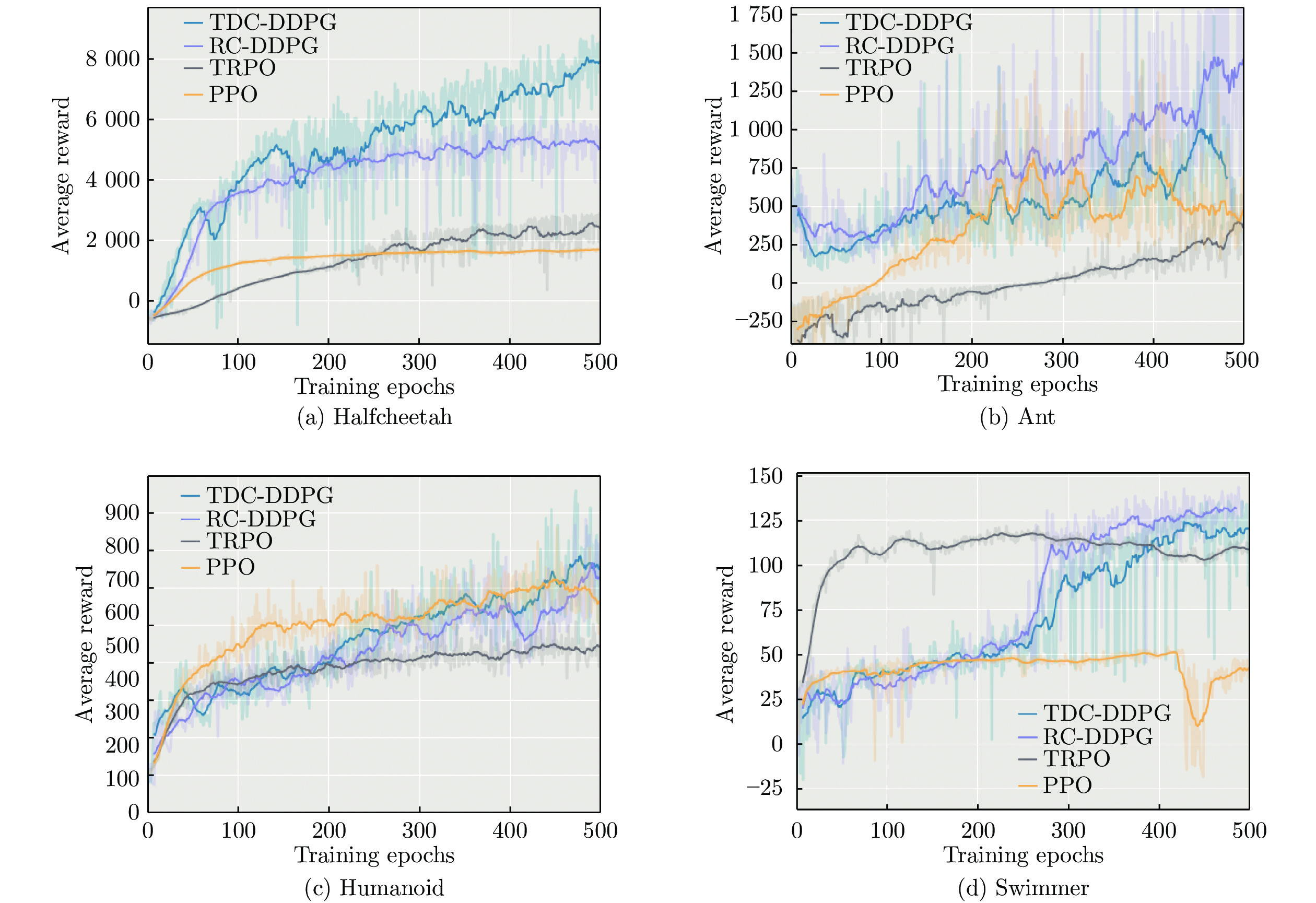

RC-DDPG方法根据经验样本中的立即奖赏值进行分类, 具体分类方法与TDC-DDPG方法相同. CER-DDPG算法结构如图1所示.

图1中, 在每一时间步

分类经验回放中最关键的是经验样本分类的衡量标准. 本文提出的CER-DDPG方法分别采用经验样本中的TD-error和立即奖赏值对样本进行分类.

1) TD-error经验样本分类. DDPG算法中, 评论家采用时序差分误差的形式对行动者网络做出的动作选择进行评价, 网络参数更新时使用一步自举的方式计算TD-error, TD-error反映了Agent从当 前状态经验样本中的学习进度, 利用TD-error尤其适用于增量式DRL算法参数的更新. 因此, TDC-DDPG中根据经验样本TD-error进行分类, 认为TD-error大的经验样本对神经网络参数更新幅度更大, 重要性程度更高, 并将TD-error值大于平均值的经验样本存入经验缓冲池1中.

2)立即奖赏经验样本分类. 神经科学研究表明啮齿动物在清醒或睡眠期间海马体中会重播先前经历的序列, 与奖赏相关的序列会更频繁地被重播[15-16]. 受到该观点启发, RC-DDPG方法中根据经验样本中的立即奖赏值对样本进行分类, 认为立即奖赏值大的经验样本重要性程度更高, 将立即奖赏值大于平均值的经验样本存入经验缓冲池1中, 其余存入经验缓冲池2中.

2.2 算法

为更有效地利用经验样本以及提高经验回放机制的效率, 将对经验样本的分类方法应用到DDPG算法中, 提出的CER-DDPG算法描述如算法1所示:

算法1. 采用分类经验回放的深度确定性策略梯度方法

1) 初始化行动者网络

2)

3) 初始化探索噪声

4) 获取初始状态

5)

6) 选择动作

7) 执行动作

8) 根据经验样本

9) 从

10) 计算

11) 通过最小化损失函数

12) 通过策略梯度方法更新行动者网络:

13) 更新目标网络:

14)

15)

算法1中, 第3步为对行动者网络添加探索噪声过程, 第

由于不同任务中Agent每一时刻获得的立即奖赏值不同, 因此产生的经验样本TD-error和立即奖赏值存在差异, 难以采用固定数值作为分类的衡量标准. CER-DDPG方法中, 使用TD-error和立即奖赏平均值进行样本分类, 并且在产生经验样本过程中不断更新TD-error和立即奖赏平均值, 能够动态性地将不同经验样本准确分类. 分类经验回放方法相比普通经验回放方法仅增加了

3. 实验

为验证CER-DDPG方法的有效性, 在OpenAI Gym工具包中MuJoCo环境下进行实验测试. MuJoCo环境包含了一系列具有连续动作空间的RL任务, 本文分别在HalfCheetah、Ant、Humanoid、Walker、Hopper和Swimmer任务中进行测试. 实验以深度确定性策略梯度(DDPG)算法作为baseline, 分别以TD-error分类的深度确定性策略梯度(TDC-DDPG)方法和立即奖赏分类的深度确定性策略梯度(RC-DDPG)方法进行对比实验.

3.1 实验参数设置

为保证实验对比公平性, 本文实验参数设置与参考文献中DDPG算法一致, TRPO与PPO算法来自OpenAI baselines算法集. 对行动者网络添加的噪声均使用参数相同的Ornstein-Uhlenbeck噪声分布, 每批次样本数量均相等. DDPG中, 经验缓冲池大小设置为1000000, 批次选取样本数量取

3.2 实验结果及分析

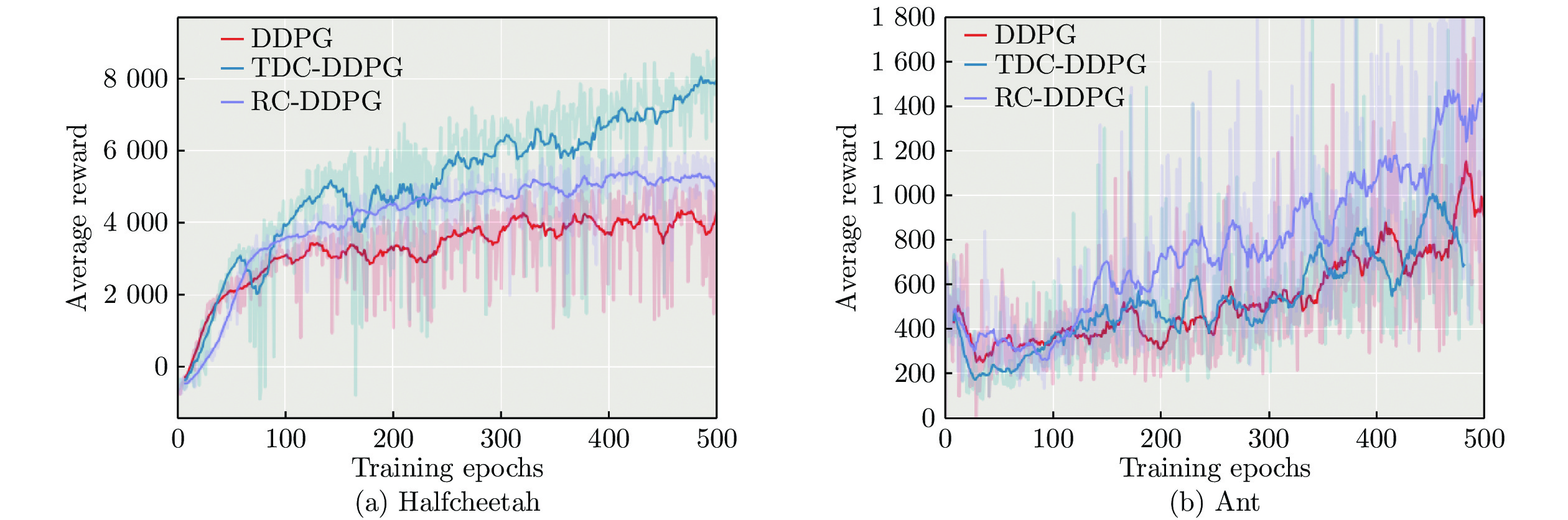

图2展示了在不同任务中3种算法的实验效果, 每个任务训练500个阶段, 每阶段包含2000个时间步, 通过对比每个训练阶段获得的平均累积奖赏衡量算法优劣.

如图2所示, 在大多数任务中TDC-DDPG和RC-DDPG算法性能优于随机选取经验样本的DDPG算法, 说明采用分类经验回放的方法能够选取到对网络模型学习更有效的经验样本, 在相同训练阶段内学习到累积奖赏更高的策略.

在HalfCheetah任务中, 通过控制双足猎豹Agent快速奔跑获取奖赏. 在网络模型训练的初始阶段中3种算法均能够取得较快学习速度. 而第20个训练阶段后, DDPG算法表现趋于平稳, TDC-DDPG和RC-DDPG算法仍然能够以较快的学习速度提升算法性能, 最终训练阶段具有明显优势.

在Humanoid和Swimmer任务中, 训练初始阶段TDC-DDPG和RC-DDPG算法优势并不显著, 随着训练时间步的增加, 在训练阶段后期算法优势逐渐明显. 因为在这两个任务中, 每一时间步Agent获得的立即奖赏值在很小的范围内波动, 导致RC-DDPG方法中两个经验缓冲池中样本类型很相近, TDC-DDPG方法根据经验样本TD-error分类, 立即奖赏值同样会影响到TD-error的大小, 因此初始训练阶段算法性能优势表现不明显. 然而在Walker任务中, 每一时间步获得的立即奖赏值大小不均导致3种算法训练得到的实验结果波动性均较大, 但本文提出方法实验效果更优.

Hopper任务通过控制双足机器人Agent向前跳跃获取奖赏. 由于状态动作空间维度低, Agent会执行一些相似动作导致经验样本相似, 因此分类经验回放方法性能提升不明显.

表1展示了500个训练阶段内3种算法在不同任务中所取得的平均奖赏值、最高奖赏值以及标准差.

从表1可以看出, 与DDPG方法相比, TDC-DDPG和RC-DDPG方法取得的平均奖赏和最高奖赏值更高, 不同训练阶段累积奖赏值差异更大, 导致标准差更大.

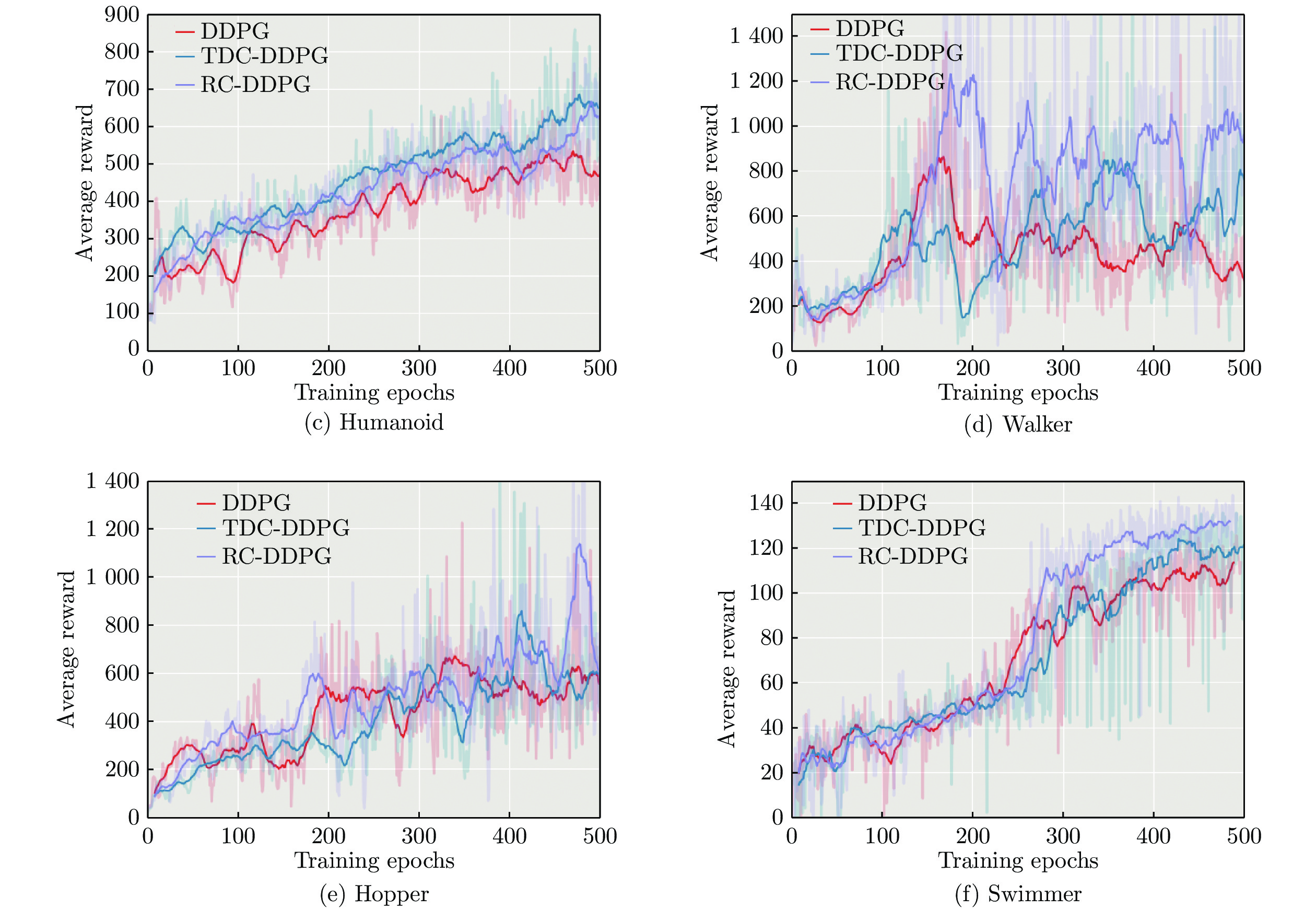

为进一步证明算法的有效性, 在HalfCheetah、Ant、Humanoid和Swimmer任务中增加了与TRPO算法以及PPO算法的对比实验. 从图3可看出, TDC-DDPG和RC-DDPG方法在与最新策略梯度算法比较中同样取得了更好的实验效果.

4. 结束语

DDPG算法在解决连续动作空间RL问题上取得了巨大成功. 网络模型学习过程中, 使用经验回放机制打破了经验样本之间存在的时序相关性. 然而经验回放未考虑不同经验样本的重要性, 不能有效利用样本数据, 对样本设置优先级又增加了算法时间复杂度. 因此, 本文提出分类经验回放方法并利用经验样本的TD-error和立即奖赏值进行分类存储用于解决经验回放中存在的问题. 在具有连续状态动作空间RL任务中的实验结果表明, 本文提出的TDC-DDPG和RC-DDPG方法在连续控制任务中表现更优.

- 别被这个老掉牙的报纸理论版投稿邮箱误导了!最新核实91个报纸理论版投稿邮箱通道,一次集齐

- 喜报!《中国博物馆》入选CSSCI扩展版来源期刊(最新CSSCI南大核心期刊目录2025-2026版)!新入选!

- 2025年中科院分区表已公布!Scientific Reports降至三区

- 国内核心期刊分级情况概览及说明!本篇适用人群:需要发南核、北核、CSCD、科核、AMI、SCD、RCCSE期刊的学者

- CSSCI官方早就公布了最新南核目录,有心的人已经拿到并且投入使用!附南核目录新增期刊!

- 北大核心期刊目录换届,我们应该熟知的10个知识点。

- 注意,最新期刊论文格式标准已发布,论文写作规则发生重大变化!文字版GB/T 7713.2—2022 学术论文编写规则

- 盘点那些评职称超管用的资源,1,3和5已经“绝种”了

- 职称话题| 为什么党校更认可省市级党报?是否有什么说据?还有哪些机构认可党报?

- 《农业经济》论文投稿解析,难度指数四颗星,附好发选题!

0373-5939925

0373-5939925 2851259250@qq.com

2851259250@qq.com